Onze reis begint in maart 1956, toen de film Forbidden Planet verscheen. In deze film wordt een belangrijke rol vervuld door Robby de Robot, algemeen beschouwd als de eerste science fiction robot in een film. Enkele maanden later houdt een kleine groep computerwetenschappers, geleid door John McCarthy, een workshop van zes weken op Darthmouth College in New Hampshire. Onderwerp van de workshop: ‘Kunstmatige Intelligentie’, een term die McCarthy zelf bedacht.

Hij definieerde dat als volgt: ‘elk aspect van leren en elke eigenschap van intelligentie kan in principe zo nauwkeurig worden omschreven dat een machine deze moet kunnen simuleren. De groep ging aan het werk, en legde de fundering voor de kunstmatige intelligentie van vandaag. Wat gebeurde er sindsdien?

Geen vooruitgang

Tijdens de eerste jaren voorspelden veel wetenschappers wat ze dachten te zullen gaan bereiken, maar ze bleken het volledig mis te hebben. Het lukte alsmaar niet om significante vooruitgang te boeken. De verwachtingen waren hoog en resultaten werden nauwelijks geboekt. Op een gegeven moment was het geld op en werden projecten noodgedwongen stopgezet. Alleen de meest fanatieke mensen bleven over.

Marvin Minsky, onderdeel van dat eerste team onderzoekers, werd het symbool van deze desillusie. In 2001 gaf hij een toespraak met de titel ‘Het is 2001. Waar is HAL?’, daarmee refererend aan de computer HAL in de Kubrick-film 2001: A Space Odyssey. Saillant detail: in 1968 was Minsky één van de experts die Kubrick bij de film betrok. In zijn praatje heeft Minsky het over het gebrek aan gezond verstand: “Er is geen programma dat een kat van een hond kan onderscheiden, dat objecten in kamers kan herkennen, of vragen beantwoorden zoals vierjarigen dat kunnen.” Met andere woorden: artificial intelligence aiI) is leuk om mee te spelen in een laboratorium, maar gaat in de echte wereld nooit iets bereiken. Einde verhaal, zou je zeggen.

Startups

Terwijl wetenschappers steeds wanhopiger werden, vond aan de Amerikaanse westkust een aantal startups de wereld opnieuw uit. Hun webplatforms groeiden in hoog tempo, gebruikers werden met miljoenen tegelijk toegevoegd en enorm veel data werd verzameld. En die databerg bleek een goudmijn. Met standaard hardware bouwden deze bedrijfjes dataverwerkingsplatforms waarmee ze ruwe data konden ‘crunchen’, daar inzichten uithalen en die weer omzetten in winst.

Een enorme mijlpaal werd in december 2004 bereikt, toen Google de beroemde Map Reduce-paper uitbracht. Daarin omschreven ze een ‘programmeringsmodel en bijbehorende implementatie voor verwerking en generatie van grote datasets’. Yahoo wilde niet achteropraken en implementeerde daarom snel een eerste versie van het project. In april 2006 was Hadoop geboren. Dat deed het vuur van machine learning ontbranden en de rest is geschiedenis.

In 2010 is machine learning gemeengoed. Klanten hebben veel opties, van DIY tot machine learning as a service (MLaaS). Alles gaat goed in dataland – of toch niet? Hoewel machine learning applicaties ‘slimmer’ maakt, is er op het gebied van kunstmatige intelligentie geen vooruitgang geboekt. HAL is, met andere woorden, nog niet gebouwd. Waarom niet?

Feature extraction

Een van de eerste stappen bij het bouwen van een machine learning-applicatie is zogenoemde ‘feature extraction’. In een notendop: de stap waarbij datawetenschappers de dataset onderzoeken om erachter te komen welke variabelen betekenisvol zijn bij het voorspellen en classificeren van data, en welke niet. Hoewel dat nog steeds veelal met de hand gebeurt, werkt het goed met gestructureerde en semi-gestructureerde data, zoals weblogs of salesgegevens

Het werkt echter niet voor complexe ai-problemen, zoals computervisie of computerspraak. Het is namelijk niet mogelijk om formeel te definiëren wat de features zijn: bijvoorbeeld, wat maakt een kat een kat? En hoe verschilt een kat van een hond? Of van een leeuw? Met andere woorden, traditionele machine learning lost dit soort problemen niet op. Daarom zijn nieuwe gereedschappen nodig. Kom er maar in, neurale netwerken!

Back to the future

Nieuwe tools dus? Zeker niet. Al in 1957 ontwierp Frank Rosenblatt een elektromechanisch neuraal netwerk, ‘Perception’, dat hij trainde om afbeeldingen te herkennen. In 1975 publiceerde Paul Werbos een artikel waarin ‘backpropagation’ werd omschreven, een algoritme waarmee neurale netwerken beter en sneller getraind konden worden. Als neurale netwerken er zo lang geweest zijn, moeten ze gedeeltelijk verantwoordelijk zijn voor mislukte ai-pogingen, toch? Moeten ze echt opnieuw tot leven worden gewekt? Waarom zou dat nu wel goed gaan?

Het zijn valide vragen. Laten we eerst eens kijken naar hoe neurale netwerken werken. Een neuron is een simpele constructie, die input combineert tot een resultaat. Ze zijn georganiseerd in lagen, waarbij de output van elke neuron in laag ‘n’ fungeert als een input in laag ‘n+1’. De eerste laag heet de inputlaag en wordt gevoed met inputdata, laten we zeggen de pixelwaarden van een afbeelding. De laatste laag heet de outputlaag en toont een bepaald resultaat, laten we zeggen een categorienummer voor een afbeelding (‘dit is een hond’).

Het mooie van neurale netwerken is dat ze zichzelf kunnen organiseren. Geef ze een dataset die groot genoeg is (laten we zeggen, afbeeldingen als inputs en categorielabels als outputs) en een neuraal netwerk is in staat automatisch juiste antwoorden te produceren. Dankzij een iteratief trainingsproces kan het ontdekken welke functionaliteiten afbeeldingen categoriseren en worden verbindingen voortdurend aangepast om het beste resultaat te bereiken – dat met de kleinste kans op fouten.

De trainingsfase en automatische ontdekking van functionaliteiten zijn goed aangepast om informele problemen op te lossen, maar er is een maar: er komen een hoop berekeningen bij kijken, die alleen maar toenemen naarmate de datagrootte toeneemt (denk aan afbeeldingen met hoge resolutie). Dit probleem wordt de ‘vloek van dimensionaliteit’ genoemd en is één van de belangrijkste redenen waarom neurale netwerken decennia lang stillagen. Er was simpelweg niet genoeg rekenkracht beschikbaar om ze op schaal te draaien.

Genoeg data was er evenmin. Neurale netwerken hebben een hoop data nodig om goed te kunnen leren. Hoe meer data, hoe beter dus! Tot voor kort was het niet mogelijk om zulke grote hoeveelheden data te verzamelen en op te slaan. Wie herinnert zich de ponskaarten en floppydisks nog?

Een significante doorbraak vond plaats in 1998, toen Yann Le Cun de ‘convolutionele neurale netwerken’ uitvond, een nieuw soort netwerken met meerdere lagen. In een notendop zijn ze in staat om eigenschappen efficiënt te bepalen, maar de omvang van de invoerdata kunnen verminderen. Daardoor kunnen kleinere netwerken gebruikt worden voor classificatie, wat de kosten van netwerktraining sterk vermindert. Deze benadering was zo succesvol, dat banken deze adopteerden ter herkenning van handschriften op checks. Een stap in de goede richting voor neurale netwerken – maar het beste moest nog komen!

The (Neural) Empire Strikes Back

Aan het einde van de jaren nul maakten drie nagenoeg gelijktijdige gebeurtenissen neurale netwerken op grote schaal mogelijk.

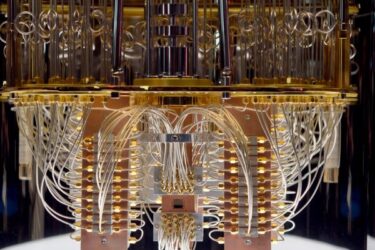

Ten eerste werden grote datasets breed beschikbaar. Tekst, afbeeldingen, films, muziek: alles was plots digitaal en kon worden gebruikt om neurale netwerken te trainen. Vandaag de dag bevat de ImageNet-database meer dan veertien miljoen gelabelde afbeeldingen. Onderzoekers over de hele wereld gebruiken deze om het meest succesvolle afbeeldingsdetectie- en classificatiesysteem te bouwen. Vervolgens waren onderzoekers in staat om de spectaculaire parallelle processorkracht van de graphics processing units (gpu’s) te gebruiken om grote neurale netwerken te trainen. Kun je geloven dat degene die de 2015 en 2016 ImageNet-competitie wonnen respectievelijk 152 en 269 lagen bezitten? Ten laatste bracht de cloud computing elasticiteit en schaalbaarheid naar ontwikkelaars en onderzoekers, zodat ze zo veel infrastructuur als nodig konden gebruiken voor training – zonder deze te hoeven bouwen, draaien of betalen op de lange termijn.

De combinatie van deze drie factoren hielpen neurale netwerken met het vervullen van hun zestig jaar oude belofte: state of the art-netwerken zijn nu in staat afbeeldingen sneller en accurater dan mensen te herkennen (met een foutmarge van minder dan 3 procent, in vergelijking met 5 procent voor mensen). Apparaten als de Amazon Echo snappen gesprekken niet alleen, maar praten ook terug. Zelfrijdende auto’s worden een realiteit. En de lijst ai-toepassingen groeit nog elke dag. Is jouw idee de volgende?

Julien Simon, evangelist machine learning & artificial intelligence bij Amazon Web Services